Testing algorithms for detecting blurry images

The purpose of the study is to collect dataset (images) for automatic testing of blurry image detection algorithms.

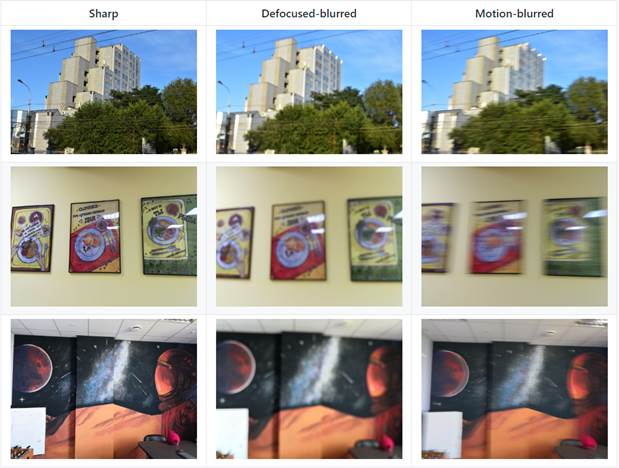

Research Methods. The following requirements are put forward for the collected dataset: the dataset must include triplets of images of various scenes. One triplet of images has three images: a clear, defocused and motion blurred image. In addition, in order to avoid distortion of the results, it is necessary to use as many physical devices as possible to obtain images. To collect data, the crowdsourcing platform Yandex.Toloka was used. In this platform, the workers (tolokers) were tasked with making three photographs of the same scene: clear, defocused, and blurred in motion. For screening of poor-quality performance, manual post-verification by the authors was used. In addition, the collected dataset excludes different triplets (clear, defocused and blurry in motion) of images of the same scene or object.

Results. The result of the study is a collected and described dataset located at https://github.com/Kwentar/blur_dataset/. We also developed a method for the automatic generation of synthetic blurry images that can be used in the machine learning algorithms.

Conclusion. The collected dataset of images can be used both to check the quality of the work of blurry image detection methods and algorithms, and to configure these methods and algorithms.

Keywords: Image processing, image dataset, blurry image detection, blurry image generation

Введение. В настоящее время генерируется огромное количество фотографий, используемых в самых различных сферах жизни: любительские, спутниковые, микроскопические. В силу влияния внешних факторов или в случае неправильных настроек апертуры, изображения получаются размытыми. Основные причины появления размытия изображений – движение сцены или устройства захвата изображения и неверно выставленное фокусное расстояние. Задача автоматического детектирования размытых изображений является актуальной, необходимой для предварительной фильтрации фотографий, с целью обнаружения и отделения изображений с неудовлетворительным качеством для того, чтобы не обрабатывать их в дальнейшем [1,11,12]. Для создания методов автоматического детектирования размытых изображений необходимы эталонные наборы изображений для последующей оценки качества решений. На данный момент существует ряд наборов данных, такие как [2,3], однако они обладают рядом существенных недостатков – малое количество устройств, на некоторых изображениях отдельное размытие объекта от фона, часть размытых изображений сгенерированы синтетически [4,5]. Целью данной работы являлось создание набора изображений, предназначенного для автоматической проверки качества работы алгоритмов и реализации методов детектирования размытых изображений.

Материалы и методы. Описание собранного набора размытых и четких изображений. Для тестирования методов и алгоритмов автоматического детектирования размытых изображений был составлен набор изображений. К процессу формирования данного набора выдвигались следующие требования:

1. Объем выборки - набор изображений должен содержать не менее 1000 изображений;

2. Необходимо произвести значительное разнообразие сцен и объектов на изображениях;

3. Необходимо использовать как можно большее разнообразие устройств, с помощью которых возможно получить изображения, включая как мобильные устройства (смартфоны), так и фотоаппараты (зеркальные и не зеркальные).

4. Для каждой сцены необходимо получить 3 изображения: четкое, размытое в движении (получалось с помощью большого значения выдержки и движения устройства захвата изображения) и расфокусированное (получалось неверной установкой фокуса на устройстве захвата изображения).

Для выполнения выдвинутых требований с целью формирования набора изображений было решено использовать краудсорсинговую платформу Яндекс.Толока [3]. Применение этой платформы дает возможность использовать большое разнообразие устройств и сцен исполнителей (толокеров), кроме того, обеспечить повышение скорости сбора данных.

С целью проведения исследований был сформирован набор данных, состоящий из 1050 изображений, при этом изображения представлены тройками (всего 350 троек). Каждая тройка представляет фотографию одной и той же сцены (примерное соответствие, не «пиксел в пиксел»). Первое изображение четкое, второе – расфокусировано, а третье смазано в движении. Изображение в тройке гарантированно имеют один и тот же размер (ширина и высота).

Набор данных формировался с помощью различных устройств, всего представлено 66 устройств, более 10 снимков, получены с 8 устройств. Большая часть устройств - это смартфоны, также представлено несколько фотоаппаратов.

Структура набора данных следующая: три папки: sharp, defocused-blurred и motion-blurred. В каждой папке по 350 соответствующих изображений.

Имя каждого файла имеет следующую структуру:

<id>_<device>_<type>.<extension>,

где id – уникальный идентификатор изображения, число от 0 до 349,

device – устройства захвата изображения,

type – тип изображения, одно из трех возможных [S, F, M], где

· S – четкое изображение (sharp),

· F – расфокусированное изображение (defocused-blurred),

· M – смазанное в движении изображение (motion-blurred).

Примеры изображений приведены на рисунке 1.

Рисунок 1 – пример изображений из набора данных

Figure 1 – example of images from dataset

Генерация размытых изображений.

Формальная модель процесса размытия изображения (1) представлена в виде

Соответственно, для генерации размытых изображений необходимо иметь четкое изображение, искажающую функцию (или функция рассеяния точки, ФРТ) и аддитивный шум.

Причины возникновения аддитивного шума n(x,y) различны и обуславливаются физическими процессами, возникающими в цифровых сенсорах. При этом на величину шума влияет большое количество параметров, таких как: тип фотоматрицы сенсора, условия освещения, параметры съемки и др. В большинстве случаев шум является гауссовым, аддитивным, и не зависит от координат пикселя на изображении. В данной работе для имитации шума использовали прибавление гауссова шума к результату операции свертки, применительно к каждому из цветных каналов [6]. При этом величина шума изменялась с целью повышения обобщающей способности сети.

Результаты. Для генерации размытых изображений необходимо определить искажающую функцию, или функцию рассеивания точки (ФРТ). В данной работе под ФРТ подразумевается 2D изображения небольших размеров (до 128х128 пикселей).

В случае расфокусированных изображений функция рассеяния точки представляет собой «пятно», близкое к кругу. Размер пятна определяется тем, насколько далеко объект от точки фокуса и открытостью диафрагмы (чем дальше от точки фокуса – тем больше пятно при одной и той же диафрагме, и чем сильнее открыта диафрагма – тем больше при одном и том же расстоянии). Более того, в силу наличия шумов, пятно неравномерно. Пример реальных ФРТ, полученных фотографированием близкого к точечному источнику света приведен на рисунке 2 а).

Алгоритм генерации ФРТ расфокусированных изображений состоит из этапов:

1. Определение размера, число от 16 до 128;

2. Определение количества углов, от 6 до 20, также возможен идеальный круг с вероятностью 0,2;

3. Генерация заданной формы;

4. Применение сжатия до 15% с вероятностью 0,1;

5. Добавление шума на полученную ФРТ.

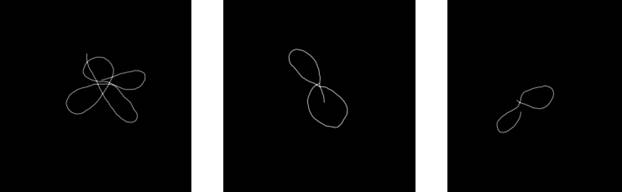

Примеры сгенерированных ФРТ приведены на рисунке 2 b) и 2 с). Для сравнения проекции сгенерированного и реального ФРТ представлены на рисунке 3 .

a) б) в)

Рисунок 2 – примеры расфокусированной ФРТ. a) – реальная ФРТ,b ) and c) – сгенерированная ФРТ.

Figure 2 – examples of defocuses PSF. a) – Real PSF, b) and c) – generated PSF.

Рисунок 3 – проекции сгенерированной и реальной ФРТ

Figure 3 – projection of generated and real PSF

Для смазанных в движении изображений был реализован алгоритм, приведенный в [7]. Примеры сгенерированных ФРТ с помощью данного алгоритма приведены на рисунке 4, а на рисунке 5 показаны примеры сгенерированных размытых изображений.

Рисунок 4 – Примеры сгенерированных ФРТ для размытия в движении.

Figure 4 – Examples of generated PSF for motion blur

Рисунок 5 - Пример работы метода генерации синтетических изображений, а) исходное, б), в) и г) – сгенерированные

Figure 5 – Example of results of synthetic blur images generation method, a) source image, б), в) and г) – generated images

Обсуждение результатов. Методы детектирования размытых изображений можно разделить на две категории: методы «классического машинного зрения», которые построены на аналитических формулах и предположениях и методы глубокого машинного обучения, в основе которых лежит использование больших наборов данных и, в общем случае, нейронных сетей. Самым робастным примером из первой группы являются методы на основе дисперсии оператора Лапласа [8]. Вторая группа включает методы, которые позволяют детектировать размытие на изображениях и автоматически вычислять ФРТ [9,10].

Заключение. Собранный набор изображений может быть использован как для проверки качества работы методов и алгоритмов детектирования размытых изображений, так и для настройки этих методов и алгоритмов. Предложенный метод генерации размытых изображений может быть использован в алгоритмах и методах детектирования размытых изображений, основанных на машинном обучению и требующих большого объема данных для процесса обучения.

Работа выполнена при частичной поддержке РФФИ и администрации Волгоградской области (гранты 18-07-00220, 19-07-00020, 19-47-343001, 19-47-340003, 19-47-340009, 19-47-340013, 19-47-343002, 19-37-90060, 20-07-00502).

Список использованных источников

1. Алексеев, А.В. Automatic coloring of grayscale images based on intelligent scene analysis / А.В. Алексеев, В.Л. Розалиев, Ю.А. Орлова // Pattern Recognition and Image Analysis (Advances in Mathematical Theory and Applications) (Москва). - 2015. - Vol. 25, No. 1. - C. 10-21.

2. E. Mavridaki, V. Mezaris, "No-Reference blur assessment in natural images using Fourier transform and spatial pyramids", Proc. IEEE International Conference on Image Processing (ICIP 2014), Paris, France, October 2014.

3. "Discriminative Blur Detection Features", Jianping Shi, Li Xu, Jiaya Jia IEEE Conference on Computer Vision and Pattern Recognition (CVPR), 2014

4. Drutsa, A., Farafonova, V., Fedorova, V., Megorskaya, O., Zerminova, E., & Zhilinskaya, O. (2019). Practice of Efficient Data Collection via Crowdsourcing at Large-Scale. https://arxiv.org/abs/1912.04444

5. Context-Sensitive Image Analysis for Coloring Nature Images / А.В. Алексеев, В.Л. Розалиев, Ю.А. Орлова, А.В. Заболеева-Зотова // Proceedings of the First International Scientific Conference «Intelligent Information Technologies for Industry» (IITI’16) (Rostov-on-Don – Sochi, Russia, May 16-21, 2016). Vol. 2 / ed. by A. Abraham [etc.]. – [Switzerland] : Springer International Publishing, 2016. – P. 133-141. – (Ser. Advances in Intelligent Systems and Computing ; Vol. 451).

6. Two-Stage Segmentation Method for Context-Sensitive Image Analysis / А.В. Алексеев, Ю.А. Орлова, В.Л. Розалиев, А.В. Заболеева-Зотова // Knowledge-Based Software Engineering : Proceedings of 11th Joint Conference, JCKBSE 2014 (Volgograd, Russia, September 17-20, 2014) / ed. by A. Kravets, M. Shcherbakov, M. Kultsova, Tadashi Iijima ; Volgograd State Technical University [etc.]. – [Б/м] : Springer International Publishing, 2014. – P. 331-340. – (Series: Communications in Computer and Information Science ; Vol. 466).

7. Kupyn, O., Budzan, V., Mykhailych, M., Mishkin, D., & Matas, J. (2018). DeblurGAN: Blind Motion Deblurring Using Conditional Adversarial Networks. Proceedings of the IEEE Computer Society Conference on Computer Vision and Pattern Recognition, 8183–8192. https://doi.org/10.1109/CVPR.2018.00854

8. Bansal, R., Raj, G., & Choudhury, T. (2016). Blur image detection using Laplacian operator and Open-CV. 2016 International Conference System Modeling Advancement in Research Trends (SMART), 63–67. https://doi.org/10.1109/SYSMART.2016.7894491

9. Li, L., Pan, J., Lai, W. S., Gao, C., Sang, N., & Yang, M. H. (2019). Blind Image Deblurring via Deep Discriminative Priors. International Journal of Computer Vision, (June 2018). https://doi.org/10.1007/s11263-018-01146-0

10. Zhang, J., Pan, J., Ren, J., Song, Y., Bao, L., Lau, R. W. H., & Yang, M. H. (2018). Dynamic Scene Deblurring Using Spatially Variant Recurrent Neural Networks. Proceedings of the IEEE Computer Society Conference on Computer Vision and Pattern Recognition, 2521–2529. https://doi.org/10.1109/CVPR.2018.00267

11. Томакова, Р.А. Метод обработки сложносегментируемых изображений с использованием многослойных морфологических операторов/Р.А.Томакова//Известия Юго-Западного государственного университета. Серия: Управление, вычислительная техника, информатика. Медицинское приборостроение. 2012. № 2-2. С.158-164.

12. Филист, С.А. Многослойные морфологические операторы для сегментации сложноструктурируемых растровых полутоновых изображений/С.А. Филист, А.Р. Дабагов, Р.А. Томакова, И.А. и [ др.]// Известия Юго-Западного государственного университета. Серия: Управление, вычислительная техника, информатика. Медицинское приборостроение. 2019.Т.9. «3(32), С.44-63.

References

1. Alekseev, A.V. Automatic coloring of grayscale images based on intelligent scene analysis / A. V. Alekseev, V. L. Rosalie, Yu. A. Orlova, A. V. // Pattern Recognition and Image Analysis (Advances in Mathematical Theory and Applications) (Москва). - 2015. - Vol. 25, No. 1. - C. 10-21.

2. E. Mavridaki, V. Mezaris, "No-Reference blur assessment in natural images using Fourier transform and spatial pyramids", Proc. IEEE International Conference on Image Processing (ICIP 2014), Paris, France, October 2014.

3. "Discriminative Blur Detection Features", Jianping Shi, Li Xu, Jiaya Jia IEEE Conference on Computer Vision and Pattern Recognition (CVPR), 2014

4. Drutsa, A., Farafonova, V., Fedorova, V., Megorskaya, O., Zerminova, E., & Zhilinskaya, O. (2019). Practice of Efficient Data Collection via Crowdsourcing at Large-Scale. https://arxiv.org/abs/1912.04444

5. Context-Sensitive Image Analysis for Coloring Nature Images / А.В. Алексеев, В.Л. Розалиев, Ю.А. Орлова, А.В. Заболеева-Зотова // Proceedings of the First International Scientific Conference «Intelligent Information Technologies for Industry» (IITI’16) (Rostov-on-Don – Sochi, Russia, May 16-21, 2016). Vol. 2 / ed. by A. Abraham [etc.]. – [Switzerland] : Springer International Publishing, 2016. – P. 133-141. – (Ser. Advances in Intelligent Systems and Computing ; Vol. 451).

6. Two-Stage Segmentation Method for Context-Sensitive Image Analysis / A. V. Alekseev, V. L. Rosalie, Yu. A. Orlova, A. V. Zabalueva-Zotova // Knowledge-Based Software Engineering : Proceedings of 11th Joint Conference, JCKBSE 2014 (Volgograd, Russia, September 17-20, 2014) / ed. by A. Kravets, M. Shcherbakov, M. Kultsova, Tadashi Iijima ; Volgograd State Technical University [etc.]. – [Б/м] : Springer International Publishing, 2014. – P. 331-340. – (Series: Communications in Computer and Information Science ; Vol. 466).

7. Kupyn, O., Budzan, V., Mykhailych, M., Mishkin, D., & Matas, J. (2018). DeblurGAN: Blind Motion Deblurring Using Conditional Adversarial Networks. Proceedings of the IEEE Computer Society Conference on Computer Vision and Pattern Recognition, 8183–8192. https://doi.org/10.1109/CVPR.2018.00854

8. Bansal, R., Raj, G., & Choudhury, T. (2016). Blur image detection using Laplacian operator and Open-CV. 2016 International Conference System Modeling Advancement in Research Trends (SMART), 63–67. https://doi.org/10.1109/SYSMART.2016.7894491

9. Li, L., Pan, J., Lai, W. S., Gao, C., Sang, N., & Yang, M. H. (2019). Blind Image Deblurring via Deep Discriminative Priors. International Journal of Computer Vision, (June 2018). https://doi.org/10.1007/s11263-018-01146-0

10. Zhang, J., Pan, J., Ren, J., Song, Y., Bao, L., Lau, R. W. H., & Yang, M. H. (2018). Dynamic Scene Deblurring Using Spatially Variant Recurrent Neural Networks. Proceedings of the IEEE Computer Society Conference on Computer Vision and Pattern Recognition, 2521–2529. https://doi.org/10.1109/CVPR.2018.00267

11. Tomakova, R. A. method for processing complex segmented images using multilayer morphological operators/R. A. Tomakova//Izvestiya Yugo-ZAPADNOGO gosudarstvennogo universiteta. Series: Management, computer engineering, computer science. Medical instrumentation. 2012. no. 2-2. Pp. 158-164.

12. Filist, S. A. multi-layer morphological operators for segmentation of complex-structured raster halftone images/S. A. Filist, A. R. Dabagov, R. A. Tomakova, I. A. and [ others]// Izvestiya Yugo-ZAPADNOGO gosudarstvennogo universiteta. Series: Management, computer engineering, computer science. Medical instrumentation. 2019.T.9. "3(32), Pp. 44-63.

Авторы

| Алексеев Алексей Владимирович | Старший преподаватель кафедры ПОАС Волгоградский технический государственный университет alekseev.yeskela@gmail.com |

| Орлова Юлия Александровна | Доцент, доктор технических наук, заведующая кафедрой "Программное обеспечение автоматизированных систем", Волгоградский технический государственный университет yulia.orlova@gmail.com |

| Розалиев Владимир Леонидович | Кандидат технических наук, доцент кафедры САПРиПК Волгоградский технический государственный университет vladimir.rozaliev@gmail.com |

| Заболеева-Зотова Алла Викторвна | Профессор, доктор технических наук, профессор кафедры "Программное обеспечение автоматизированных систем", Волгоградский технический государственный университет poas@vstu.ru |

Authors

| Alekseev Alexey Vladimirovich | Senior Lecturer at Software Engineering Department Volgograd State Technical University, alekseev.yeskela@gmail.com |

| Orlova Yulia Alexandrovna. | Docent Doctor of Technical Sciences, head of Department "Software Engineering", Volgograd State Technical University, yulia.orlova@gmail.com |

| Rozaliev Vladimir Leonidovich | Docent PhD of Technical Sciences at CAD department Volgograd State Technical University, vladimir.rozaliev@gmail.com |

| Zaaboleeva-Zotova Alla Viktorovna | Doctor of Technical Sciences, professor of Department "Software Engineering", Volgograd State Technical University, poas@vstu.ru |