В зависимости от количества включенных в модель факторов Х модели делятся на однофакторные (парная модель регрессии) и многофакторные (модель множественной регрессии).

В зависимости от вида функции  модели делятся на линейные и нелинейные.

модели делятся на линейные и нелинейные.

Модель множественной линейной регрессии имеет вид:

y i = a 0 + a 1 x i 1 + a 2 x i 2 +…+ a k x i k + e i  (1)

(1)

- количество наблюдений.

- количество наблюдений.

коэффициент регрессии aj показывает, на какую величину в среднем изменится результативный признак  , если переменную xj увеличить на одну единицу измерения при фиксированных значениях остальных переменных, входящих в модель, т. е. aj является нормативным коэффициентом. Коэффициент

, если переменную xj увеличить на одну единицу измерения при фиксированных значениях остальных переменных, входящих в модель, т. е. aj является нормативным коэффициентом. Коэффициент  может быть положительным и отрицательным.

может быть положительным и отрицательным.

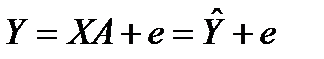

Анализ уравнения (1) и методика определения параметров становятся более наглядными, а расчетные процедуры существенно упрощаются, если воспользоваться матричной формой записи:

(2) где

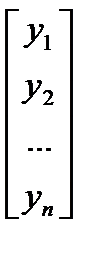

(2) где  – вектор зависимой переменной размерности п ´ 1, представляющий собой п наблюдений значений

– вектор зависимой переменной размерности п ´ 1, представляющий собой п наблюдений значений  .

.

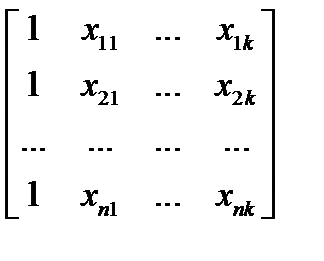

- матрица п наблюдений независимых переменных

- матрица п наблюдений независимых переменных  , размерность матрицы

, размерность матрицы  равна п ´ (k+1) . Дополнительный фактор

равна п ´ (k+1) . Дополнительный фактор  , состоящий из единиц, вводится для вычисления свободного члена. В качестве исходных данных могут быть использованы временные ряды или пространственная выборка.

, состоящий из единиц, вводится для вычисления свободного члена. В качестве исходных данных могут быть использованы временные ряды или пространственная выборка.

- количество факторов, включенных в модель.

- количество факторов, включенных в модель.

a — подлежащий оцениванию вектор неизвестных параметров размерности ( k +1) ´ 1;

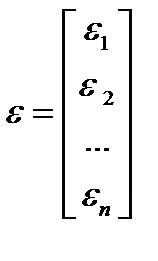

— вектор случайных отклонений (возмущений) размерности п ´ 1.

— вектор случайных отклонений (возмущений) размерности п ´ 1.  отражает тот факт, что изменение

отражает тот факт, что изменение  будет неточно описываться изменением объясняющих переменных

будет неточно описываться изменением объясняющих переменных  , так как существуют и другие факторы, неучтенные в данной модели.

, так как существуют и другие факторы, неучтенные в данной модели.

Таким образом,

Y =  , X =

, X =  ,

,  , a =

, a =  .

.

Уравнение (2) содержит значения неизвестных параметров a 0 , a 1 , a 2 ,… , a k  . Эти величины оцениваются на основе выборочных наблюдений, поэтому полученные расчетные показатели не являются истинными, а представляют собой лишь их статистические оценки. Модель линейной регрессии, в которой вместо истинных значений параметров подставлены их оценки (а именно такие регрессии и применяются на практике), имеет вид

. Эти величины оцениваются на основе выборочных наблюдений, поэтому полученные расчетные показатели не являются истинными, а представляют собой лишь их статистические оценки. Модель линейной регрессии, в которой вместо истинных значений параметров подставлены их оценки (а именно такие регрессии и применяются на практике), имеет вид

, (3)

, (3)

где A — вектор оценок параметров; е — вектор «оцененных» отклонений регрессии, остатки регрессии е = Y - ХА;  —оценка значений Y, равная ХА.

—оценка значений Y, равная ХА.

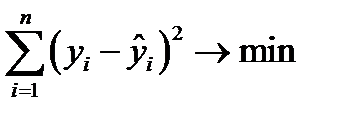

Построение уравнения регрессии осуществляется, как правило, методом наименьших квадратов (МНК), суть которого состоит в минимизации суммы квадратов отклонений фактических значений результатного признака от его расчетных значений, т.е.:

.

.

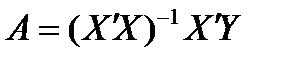

Формулу для вычисления параметров регрессионного уравнения по методу наименьших квадратов приведем без вывода

(4).

(4).

Для того чтобы регрессионный анализ, основанный на обычном методе наименьших квадратов, давал наилучшие из всех возможных результаты, должны выполняться следующие условия, известные как условия Гаусса – Маркова.

Первое условие. Математическое ожидание случайной составляющей в любом наблюдении должно быть равно нулю. Иногда случайная составляющая будет положительной, иногда отрицательной, но она не должна иметь систематического смещения ни в одном из двух возможных направлений

Фактически если уравнение регрессии включает свободный член, то обычно это условие выполняется автоматически, так как роль константы состоит в определении любой систематической составляющей  , которую не учитывают объясняющие переменные, включенные в уравнение регрессии.

, которую не учитывают объясняющие переменные, включенные в уравнение регрессии.

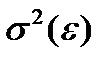

Второе условие означает, что дисперсия случайной составляющей должна быть постоянна для всех наблюдений. Иногда случайная составляющая будет больше, иногда меньше, однако не должно быть априорной причины для того, чтобы она порождала большую ошибку в одних наблюдениях, чем в других.

Эта постоянная дисперсия обычно обозначается  , или часто в более краткой форме

, или часто в более краткой форме  , а условие записывается следующим образом:

, а условие записывается следующим образом:

.

.

Выполнимость данного условия называется гомоскедастичностью (постоянством дисперсии отклонений). Невыполнимость данной предпосылки называется гетероскедастичностью, (непостоянством дисперсии отклонений).

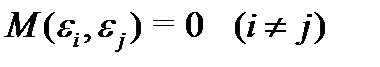

Условие независимости. Третье условие предполагает отсутствие систематической связи между значениями случайной составляющей в любых двух наблюдениях. Например, если случайная составляющая велика и положительна в одном наблюдении, это не должно обусловливать систематическую тенденцию к тому, что она будет большой и положительной в следующем наблюдении. Случайные составляющие должны быть независимы друг от друга.

Данное условие можно записать следующим образом:

Возмущения  не коррелированны. Это условие означает, что отклонения регрессии (а значит, и сама зависимая переменная) не коррелируют. Условие некоррелируемости ограничительно, например, в случае временного ряда

не коррелированны. Это условие означает, что отклонения регрессии (а значит, и сама зависимая переменная) не коррелируют. Условие некоррелируемости ограничительно, например, в случае временного ряда  . Тогда третье условие означает отсутствие автокорреляции ряда

. Тогда третье условие означает отсутствие автокорреляции ряда  .

.

Четвертое условие состоит в том, что в модели (1) возмущение  (или зависимая переменная

(или зависимая переменная  ) есть величина случайная, а объясняющая переменная

) есть величина случайная, а объясняющая переменная  - величина неслучайная.

- величина неслучайная.

Если это условие выполнено, то теоретическая ковариация между независимой переменной и случайным членом равна нулю.

Наряду с условиями Гаусса — Маркова обычно также предполагается нормальность распределения случайного члена.

В тех случаях, когда выполняются перечисленные предпосылки, оценки, полученные по МНК, будут обладать свойствами несмещенности, состоятельности и эффективности.

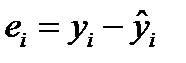

Качество модели регрессии связывают с адекватностью модели наблюдаемым (эмпирическим) данным. Проверка адекватности (или соответствия) модели регрессии наблюдаемым данным проводится на основе анализа остатков -  .

.

Анализ остатков позволяет получить представление, насколько хорошо подобрана сама модель и насколько правильно выбран метод оценки коэффициентов. Согласно общим предположениям регрессионного анализа, остатки должны вести себя как независимые (в действительности, почти независимые) одинаково распределенные случайные величины.

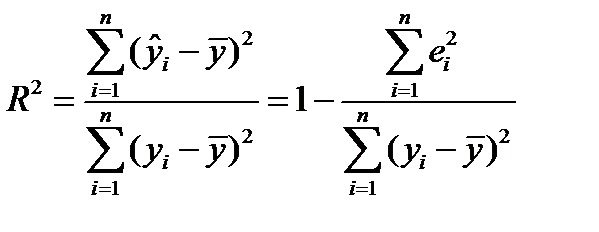

При анализе качества модели регрессии, в первую очередь, используется коэффициент детерминации, который определяется следующим образом:

, (5)

, (5)

где  - среднее значение зависимой переменной,

- среднее значение зависимой переменной,

- предсказанное (рассчитанное по уравнению регрессии) значение зависимой переменной.

- предсказанное (рассчитанное по уравнению регрессии) значение зависимой переменной.

Коэффициент детерминации показывает долю вариации результативного признака, находящегося под воздействием изучаемых факторов, т. е. определяет, какая доля вариации признака Y учтена в модели и обусловлена влиянием на него факторов, включенных в модель.

Чем ближе  к 1, тем выше качество модели.

к 1, тем выше качество модели.